長く寒い冬が去り、ようやく春がきた。石神井公園では先週から、桜、こぶし等、様々な花々が一斉に開花している。暖かい風に吹かれながら、池を散歩するのは気持ちが良い。

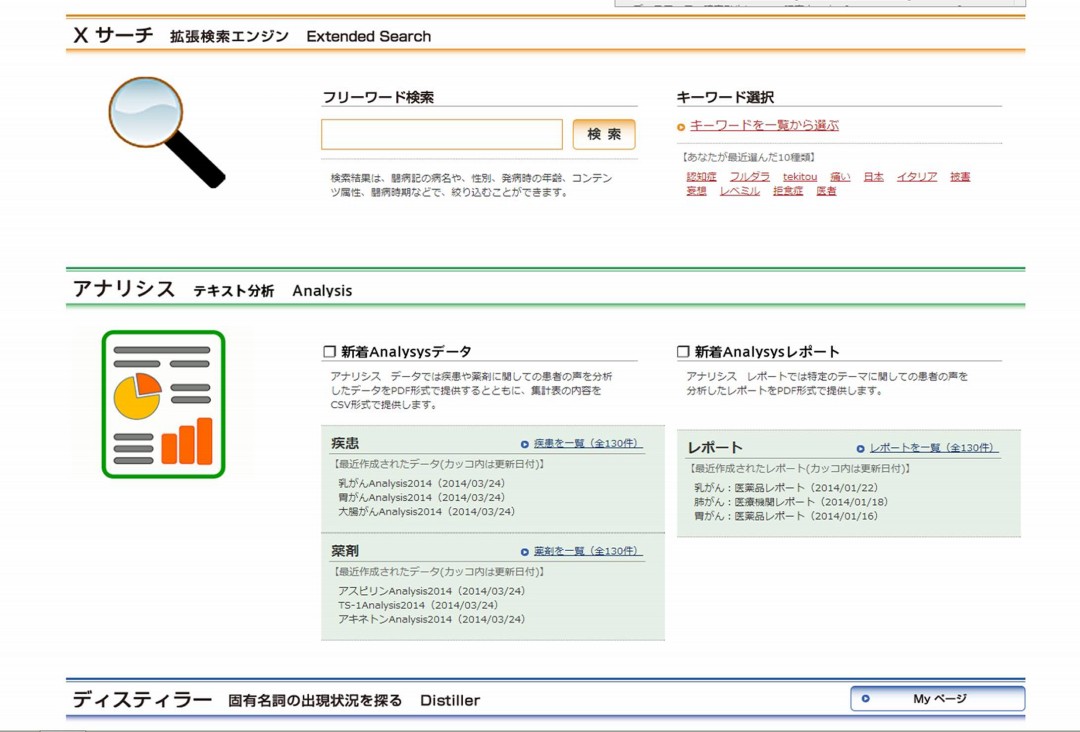

さて、以前のエントリでお知らせしたように、TOBYOプロジェクトはdimensionsの新コンテンツ「Analysis」の実装に取り組んでいるが、当初計画よりもやや遅れ気味になっている。「Analysis」では、TOBYO収録4万4千件の患者ドキュメントを集計分析し、順次パブリッシュする予定だが、従来研究してきたテキストマイニングに加え、最近、新たに「機械学習」機能を導入することを考えている。

TOBYO収録データは700万ページを越え、近い将来1000万ページも視野に入れなければならなくなってきた。こうなると、症状、治療、意思決定など闘病情報と日常雑記や趣味など生活情報、あるいはノイズなどを自動分類することがますます重要になってきている。機械学習は、まずデータ・クリーニングのために必要なのだ。

そればかりではない。患者体験ドキュメントを「時間軸上に配列された医療イベントのシークエンス」というふうに捉えるとすれば、「初期症状、検査、告知、診療方針、手術、病理結果報告・・・」などキイになる医療イベントあるいは場面を特定し、自在に抽出する機能が重要になってくる。どの疾患の、どの患者の体験であれ、今日、診療ガイドラインなどによって医療の標準化が進むにつれ、どの患者体験も同じような医療イベント群を同じようなシークエンスで配列したものと見ることさえ可能である。もちろん個々の患者体験はそれぞれ異なるものの、それら全体を俯瞰してみると、通底する同じようなパターンが浮かび上がってくる。

そのように考えると、それぞれの患者体験を個別で独立した「物語」とみなすことは、次第に困難になってきているのかもしれない。個人の病状と人生が多様であることは変わらないが、一旦それらが医療過程(システム)に入ってしまうと、患者の多様性はある限定されたパターンに収斂させられて行くかのように見える。闘病につきまとう息苦しさ、あるいはある種の無力感というものがあるとすれば、それらはこれら「限られ、決まりきった選択肢」を強いられることから生起するのだと思う。だが、このことの良し悪しの判断は、現時点では保留にしておこう。

ところで、このようなドキュメント(テキストデータ)の読み方は、大きく二つに別れるだろう。そのひとつは時間軸にそってドキュメントをシーケンシャルに読み進む方法であり、これは連続して生起するイベントを「ストーリー、物語」として読むことに他ならない。いわゆる「闘病記」として、患者ドキュメントを通読するケースである。これに対し、治療シークエンスを構成する主要なシーンあるいは場面を切り出し、その場面に出現する固有の言葉や文を横断的に集計し抽出するという読み方がある。当方が目指しているのはこれである。

実はこれら二つの「読み方」の他に、もう一つ別の読み方がある。それはテキストデータ全体を形態素分解し、その出現パターンを計量的に分析する読み方である。いわゆるテキストマイニングによるデータ解析であるが、昨年、私達はかなりつっこんでこの方法を研究してみた。ただし、その結果は必ずしも満足できるものではなかった。その原因を考えてみると、一言でいえば「すべての語、文は、コンテクストに依存する」からである。コンテクスト(前後関係)を無視して、治療法名や薬剤名など「語」の共起関係や相互距離や出現確率を算出しても、それはある限定された「語のふるまい」を切り出して見ているに過ぎない。その「語」が出現したコンテクストによって、その「語」が意味するものは変わる。テキストマイニングに足りないのは、そのことの認識である。

正直に言うと、テキストマイニングという無限ループから抜け出すためには、私達はこのようなことに気づく必要があったのだが、そのためにずいぶん時間を使ってしまった。テキストマイニングは、言われているような万能ではなく、あくまで基礎技術の一つにすぎない。じゃ、「コンテクストだから、物語の読みへ回帰する」のかと言えば、それでは旧来の「闘病記論」を反芻することになってしまう。

私達が結局たどりついたのは、語が置かれているコンテクストを「場面」で特定するという方法である。たとえばある治療法名が、どんな場面で出現しているかを特定することが重要だと気づいた。告知の場面か、医師が説明する場面か、患者が治療選択する場面か、その治療法が実施されている場面か、はたまた病理検査報告の場面か・・・。同時に、それぞれの主要「場面」において、逆にどのような語や文が出現しているかをテキストマイニングすることは非常に有効だ。そしてそれら「場面」を自動分類し、自在に抽出し、その上に「場面検索」まで可能にするためには、機械学習の技術がどうしても必要になると考えている。

テキストマイニングを含むNLP(自然言語処理)技術は、ネット上の闘病ドキュメントを解析する上で必須である。しかし、それは万能ではない。テキストマイニングに機械学習を組み合わせて、はじめて有効な患者ドキュメント分析が可能になるだろう。チャレンジは続く。

三宅 啓 INITIATIVE INC